近日,软件学院许小龙教授团队在国际顶级会议《Conference on Neural Information Processing Systems》(NeurIPS,CCF A类会议)录用了题为 “HPSERec: Hierarchical Partition and Stepwise Enhancement for Long-Tail Sequential Recommendation” 的研究论文。该研究针对推荐系统中普遍存在的长尾数据分布问题,首次提出了一种分层切分与逐步增强框架(HPSERec)。该框架通过构建分布均衡切分模型,将物品交互集合细分为多个子集,并结合逐层知识蒸馏与最优传输反馈对齐机制,在显著提升长尾物品和长序列用户推荐效果的同时,有效避免了头部物品性能下降的问题。该方法较最新的大模型增强推荐方法得到了很大提升,充分展示了其在解决长尾推荐挑战中的有效性与实用性。

Conference on Neural Information Processing Systems(NeurIPS)是中国计算机学会 CCF A类国际顶级会议,也是人工智能与机器学习领域最具影响力和权威性的学术会议之一。该会议重点关注机器学习理论、模型与算法设计、优化方法、神经网络、应用系统以及跨学科的新兴方向,每年吸引来自全球顶尖高校与研究机构的大量高水平研究成果投稿与交流。

长尾推荐由于数据分布极度不平衡,常常导致模型在头部物品上表现良好,但在尾部物品上效果不佳,甚至出现“跷跷板效应”。现有研究主要集中在头尾二分的简单划分和知识增强方法,往往忽视了长尾内部的细粒度差异,也缺乏对用户表征的一致性约束。此外,部分方法过于依赖头部知识向尾部迁移,容易产生负迁移效应。

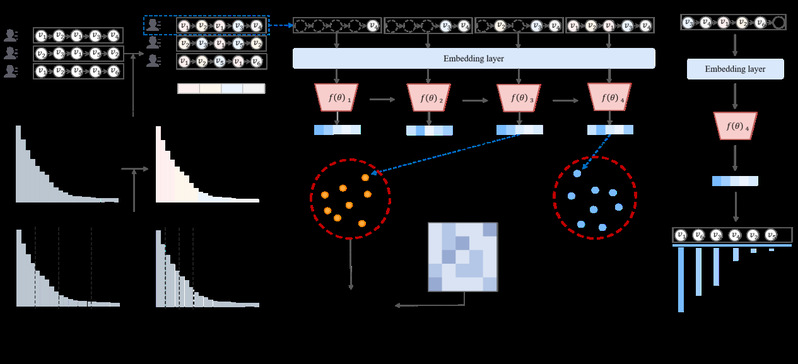

针对以上挑战,该研究提出了一种分层切分与逐步增强框架(HPSERec)。首先,该研究构建了分布均衡切分模型,通过动态规划结合失衡度量函数,实现对物品集合的多层次划分,每个子集同时兼顾交互均匀性与规模平衡。随后,该研究设计了逐步增强机制:为每个子集配置专家网络,并采用逐层累积可见物品和相邻知识蒸馏的方式,平滑地将长尾知识向全局兴趣迁移。最后,该研究引入反馈对齐模块,利用最优传输(Sinkhorn 算法)在相邻层用户表征之间进行分布级对齐,从而缓解长尾专家表征稀疏和不稳定的问题。

图1 HPSERec框架

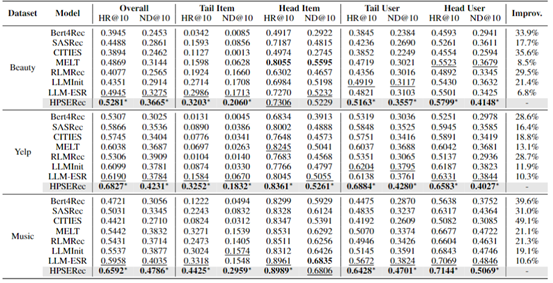

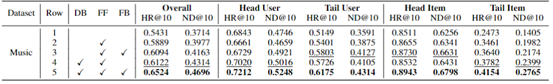

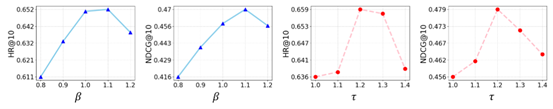

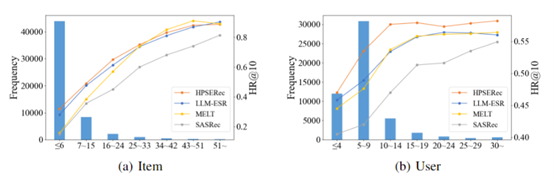

如图1所示,HPSERec 框架由分布均衡模块、前向增强模块与反馈模块组成,三者形成“切分–增强–对齐”的闭环。为了验证方法的有效性和实用性,该研究在 Yelp、Amazon Beauty 和 Amazon Music 三个真实数据集上进行了对比实验。实验考虑了不同用户序列长度和物品受欢迎度划分,以全面评估长尾与头部的性能表现。方法的有效性通过 HR@10 和 NDCG@10 等指标来衡量。部分实验结果见表1、表2、图2和图3。

表1 HPSERec与其他基线方法对比

表2 消融实验

图2 超参数实验

图3 分组实验

实验结果表明,所提出的 HPSERec 在长尾物品和长序列用户上的推荐表现显著提升,相较最先进的 LLM 增强推荐方法平均提升超过 6%–10%,同时在头部物品上保持稳定甚至小幅提升,避免了性能跷跷板效应。消融实验进一步验证了分布均衡切分、相邻蒸馏与最优传输反馈在整体性能提升中的互补作用。

该论文以南京信息工程大学为第一单位兼通讯单位,许小龙教授为第一作者,第二作者为2025级硕士新生赵旭东。

论文信息如下:

Xiaolong Xu, Xudong Zhao, Haolong Xiang, Xuyun Zhang, Wei Shen, Hongsheng Hu, Lianyong Qi. HPSERec: A Hierarchical Partitioning and Stepwise Enhancement Framework for Long-tailed Sequential Recommendation. In Neural Information Processing Systems (NeurIPS), 2025.

此外,团队许小龙教授与南京大学、澳大利亚麦考瑞大学等单位合作的论文“A Fair Federated Learning Method for Handling Client Participation Probability Inconsistencies in Heterogeneous Environments”被人工智能顶会NeurIPS接收。